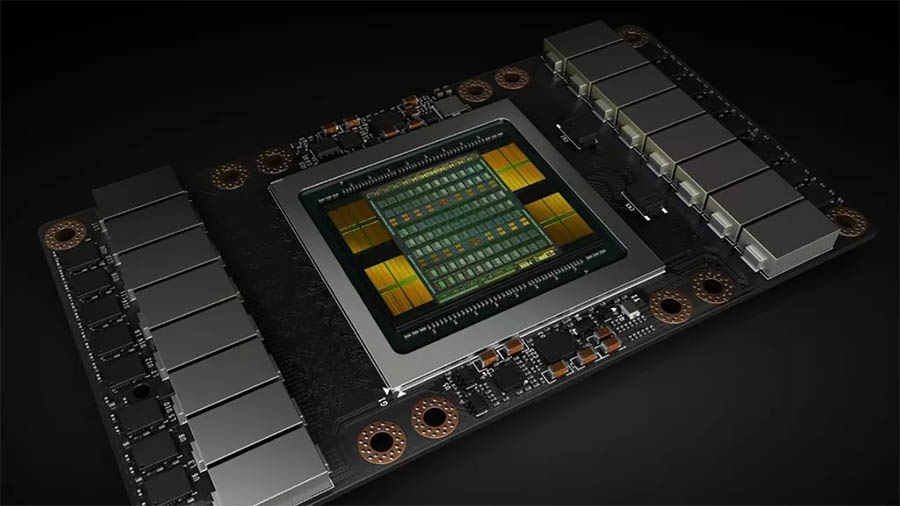

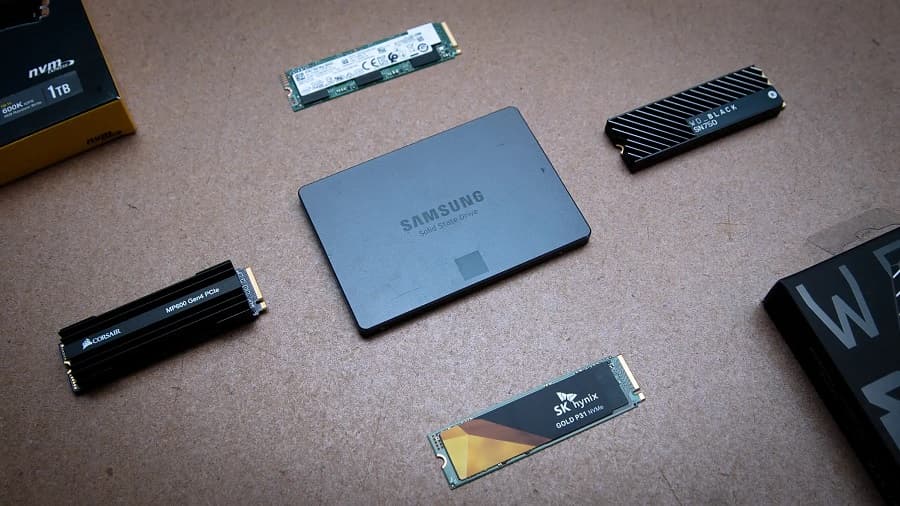

Nvidia، IBM و محققان در تلاش هستند تا آموزش ML (Machine Learning) یا همان یادگیری ماشینی را بسیار سریعتر کنند! این دو شرکت بزرگ برنامه ای دارند تا زندگی افرادی را که در حول موضوع یادگیری ماشینی کار می کنند کمی آسان تر کنند. و این برنامه اتصال مستقیم پردازنده های گرافیکی (GPU) به SSD است.

این ایده که در یک مقاله تحقیقاتی به تفصیل شرح داده شده است، حافظه شتاب دهنده بزرگ (BaM) نامیده می شود. که شامل اتصال مستقیم پردازنده های گرافیکی به حجم زیادی از فضای ذخیره سازی SSD است. که به رفع تنگنا برای ML و سایر وظایف فشرده کمک می کند.

“BaM تقویت ترافیک ورودی/خروجی را با فعال کردن رشته های GPU برای خواندن یا نوشتن مقادیر کمی از داده ها در صورت تقاضا، همانطور که توسط محاسبات تعیین می شود، کاهش می دهد.”

محققان

افزایش سرعت و قابلیت اطمینان

“هدف BaM گسترش ظرفیت حافظه GPU و افزایش پهنای باند دسترسی مؤثر به ذخیره سازی و در عین حال ارائه انتزاعات سطح بالا برای رشته های GPU است تا به راحتی به ساختار های داده های عظیم در سلسله مراتب حافظه توسعه یافته دسترسی پیدا کنند.”

هدف نهایی کاهش اتکای پردازنده های گرافیکی انویدیا به پردازنده های همه منظوره شتاب دار سخت افزاری است. با اجازه دادن به GPU های Nvidia برای دسترسی مستقیم به فضای ذخیره سازی و سپس پردازش آن، کار توسط تخصصی ترین ابزار های موجود انجام می شود.

جزئیات بیشتر

جزئیات فنی بسیار پیچیده هستند اما اصل موضوع دو چیز است. BaM از حافظه پنهان GPU که توسط نرم افزار مدیریت می شود در کنار کتابخانه ای استفاده می کند. این یعنی رشته های GPU می توانند مستقیماً داده های ذخیره شده در NVMe SSD را درخواست کنند و از منابع آن استفاده کنند.

نتیجه نهایی این است که آموزش ML و سایر فعالیت های فشرده می توانند سریع تر به داده ها دسترسی داشته باشند. و مهم تر از همه، به روش های خاصی که برای بار کاری مفید باشد. در آزمایش، این ثابت شد که GPU و SSD به خوبی با هم کار می کنند و به سرعت داده ها را انتقال می دهند. این تیم ها قصد دارند طراحی های سخت افزاری و نرم افزاری خود را منبع باز کنند تا در نهایت یک پیروزی بزرگ برای جامعه ML باشد.

منبع: techradar