از زمان ظهور دیپ فیک از اولین بار در سال 2018 این فناوری به ابزاری مؤثر و بالقوه اما خطرناک تبدیل شده است. با تکنولوژی دیپ فیک (Deepfake) یا جعل عمیق، می توان به سادگی ویدیوها و تصاویر منتشر شده از افراد مختلف را تغییر داد و آنقدر این کار را با کیفیت انجام داد که بسیار از افراد نتوانند جعلی بودن آن را تشخیص دهند.

الکساندر امینی دانشجوی دکترا در انستیتوی فناوری ماساچوست (MIT)، در جلسه افتتاحیه دوره معرفی خود در سال 2020 برای یادگیری عمیق، یک مهمان معروف را دعوت کرد: باراک اوباما، رئیس جمهور پیشین ایالات متحده.

اوباما که به کنفرانس ویدئویی پیوست گفت: “یادگیری عمیق در بسیاری از زمینه ها، از روباتیک گرفته تا پزشکی و هر چیز دیگری را متحول می کند.”

اوباما پس از صحبت کمی بیشتر درباره فضایل هوش مصنوعی بیانیه مهمی را مطرح کرد: “در حقیقت کل این گفتار و فیلم ها واقعی نیستند و با استفاده از یادگیری عمیق و هوش مصنوعی ایجاد شده اند.”

ویدیوی اوباما در واقع یک فیلم عمیق و مستند از هوش مصنوعی بود که در آن حرکات صورت یک بازیگر به یک هدف منتقل می شود.

دیپ فیک تاکنون برای افراد مشهور و سیاستمداران استفاده شده است و تهدیدی برای پنهان کردن حقیقت شمرده می شود.

دیپ فیک چگونه کار می کند؟

برنامه های دیپ فیک به روش های مختلفی کار می کنند. برخی حرکات صورت یک بازیگر را به یک فیلم هدف منتقل می کنند، مانند شخصیت اوباما که توسط کمدین جردن پیل ایجاد شده است تا درباره تهدید اخبار جعلی هشدار دهد:

سایر کار های چهره یک شخص مورد نظر را بر روی فیلم های دیگر ترسیم می کنند.

مانند اکثر برنامه های کاربردی مبتنی بر هوش مصنوعی امروزی، دیپ فیک از شبکه های عصبی عمیق استفاده می کند، نوعی الگوریتم AI که به ویژه در یافتن الگو ها و همبستگی ها در مجموعه های بزرگی از داده ها خوب است.

ثابت شده است که شبکه های عصبی به ویژه در بینایی رایانه، شاخه ای از علوم کامپیوتر و هوش مصنوعی که داده های تصویری را کنترل می کنند، بسیار خوب هستند.

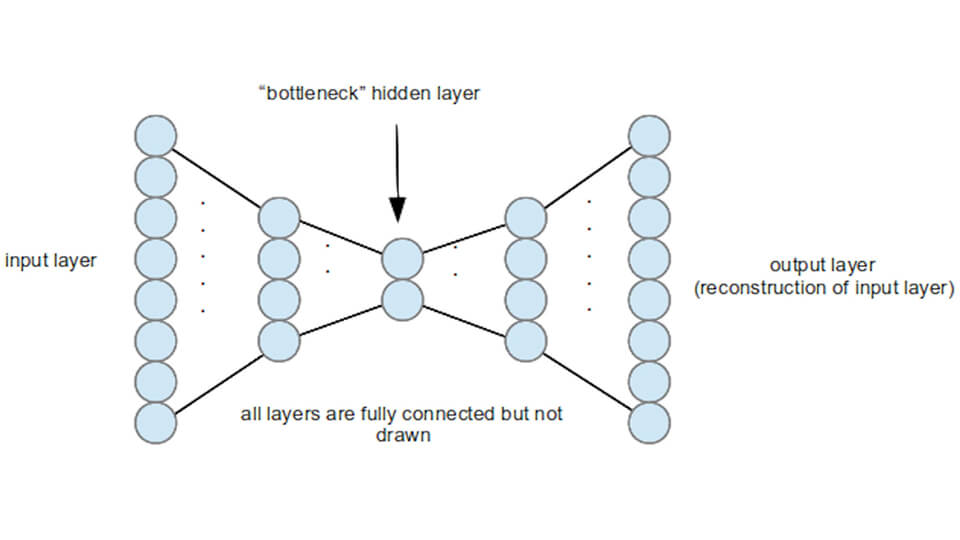

دیپ فیک از یک نوع خاص از ساختار شبکه عصبی به نام “رمز نگاری خودکار” استفاده می کند.

رمزنگاری خودکار از دو بخش تشکیل شده است: رمزگذار، که یک تصویر را به مقدار کمی از داده های فشرده تبدیل می کند و رمز گشایی که داده های فشرده شده را به تصویر اصلی بر می گرداند.

این مکانیسم شبیه به کدک های تصویری و ویدئویی مانند JPEG و MPEG است.

اما برخلاف نرم افزار رمزگذار کلاسیک که بر روی گروه های پیکسل کار می کند، این فناوری روی ویژگی های موجود در تصاویر مانند اشکال، اشیاء و بافت ها کار می کند.

این چنین فناوری، می تواند فراتر از فشرده سازی و خارج کردن از حالت فشرده معمولی باشد و کارهای دیگری را نیز انجام دهد – مثلاً تولید تصاویر جدید یا حذف نویز از تصاویر نویز دار.

هنگام تهیه تصاویر از چهره ها، یک رمزنگار خودکار، ویژگی های صورت را یاد می گیرد: چشم، بینی، دهان، ابرو و … .

برنامه های دیپ فیک از دو برنامه خودکار استفاده می کنند، یکی آموزش دیده در چهره بازیگر و دیگری آموزش دیده در چهره هدف.

این برنامه ورودی ها و خروجی ها را برای انتقال حرکات صورت بازیگر به هدف تغییر می دهد.

مطالعه بیشتر …

چه چیزی دیپ فیک را خاص می کند؟

فناوری دپ فیک تنها نوع قابل تغییر در چهره ها در فیلم ها نیست. در حقیقت صنعت VFX (جلوه های بصری) ده ها سال است که این کار را انجام می دهد.

اما قبل از دیپ فیک، این توانایی محدود به استودیو های فیلم با عمق محدود و دسترسی به منابع فنی فراوان بود.

دیپ فیک توانایی تعویض چهره ها را در ویدیو ها تغییر داده است. این فناوری اکنون در دسترس هر کسی است که یک رایانه با پردازنده مناسب و کارت گرافیک قوی (مانند Nvidia GeForce GTX 1080 ) داشته باشد یا بتواند چند صد دلار برای اجاره محاسبات ابری و GPU خرج کند.

این فناوری به تدریج در حال پیشرفت است، اما ایجاد یک دیپ فیک مناسب هنوز هم به زمان و کار فراوانی نیاز دارد.

ابتدا باید عکس های زیادی از چهره هدف و بازیگر جمع کنید و آن عکس ها باید هر چهره را از زوایای مختلف نشان دهند.

این فرایند معمولاً شامل گرفتن هزاران فریم از فیلم هایی است که هدف و بازیگر را نشان می دهد و برش آن ها فقط شامل صورت می شود.

ابزار های جدید مانند Faceswap می توانند با خودکار کردن استخراج قاب و بریدن آن ها، بخشی از کار را انجام دهند اما هنوز هم نیاز به کار فراوانی دارند.

بسته به تنظیمات سخت افزاری و کیفیت داده های آموزشی شما، آموزش مدل هوش مصنوعی و ایجاد دیپ فیک می تواند از چند روز تا دو هفته زمان ببرد.

خطرات Deepfakes

ایجاد فیلم های آموزشی جالب و بازیگران سفارشی برای فیلم های مورد علاقه شما تنها کاربرد های دیپ فیک نیست.

فیلم های دارای مدرک هوش مصنوعی دارای سمت تاریک تری نیز هستند که بسیار برجسته تر از کاربرد های مثبت آن است.

اندکی پس از انتشار اولین برنامه دیپ فیک Reddit با فیلم های جعلی که افراد مشهور و سیاستمدار را شامل می شدند، روبرو شد.

به موازات ایجاد دیپ فیک، پیشرفت سایر فناوری های مبتنی بر هوش مصنوعی نه تنها جعل صورت بلکه عملاً صدای هر کسی را ممکن ساخته است.

ظهور دیپ فیک باعث نگرانی های دیگری نیز شده است.

با گزارش های مربوط به چگونگی تسریع الگوریتم های رسانه های اجتماعی گسترش اطلاعات دروغین، تهدید بحران اخبار جعلی ناشی از فناوری دیپ فیک به ویژه هنگامی که ایالات متحده برای انتخابات ریاست جمهوری سال 2020 آماده می شد، به یک نگرانی جدی تبدیل شد.

قانون گذاران آمریكایی دیپ فیک را به عنوان تهدیدی برای امنیت ملی نشانه گذاری كرده اند و در مورد سوءاستفاده های احتمالی این فناوری برای تأثیرگذاری بر افكار عمومی، جلسات متعددی برگزار كرده اند.

تاکنون اقدامات گسترده ای برای ممنوعیت دیپ فیک و پاسخگویی به افرادی که اینگونه موارد را منتشر می کنند، از سوی دولت های مختلف، انجام شده است.

مبارزه با Deepfakes

در نسخه های اولیه دیپ فیک، با چشم غیر مسلح هم میشد جعلی بودن آن ها را دریافت. از جمله چشمک زدن غیر طبیعی چشم و تغییر رنگ غیر طبیعی پوست. اما تغییرات دیپ فیک در حال بهبود است.

محققان در حال ابداع تکنیک های جدیدی برای کشف آن بودند و می بینند که این فن آوری ها همچنان نا کارآمد هستند و از این رو این فناوری همچنان به تکامل و نتایج طبیعی تری می رسد.

در ماه سپتامبر فیس بوک، مایکروسافت و چندین دانشگاه برای توسعه ابزاری که می توانند باعث ایجاد رخداد های دیپ فیک و سایر فیلم های مستند هوش مصنوعی شوند، مسابقه ای را راه اندازی کردند.

مایکل شرودر CTO فیس بوک در مطلبی در وبلاگ خود با معرفی دیپ فیک نوشت: “این یک مشکل به طور مداوم در حال تحول است، دقیقاً مانند اسپم یا سایر چالش های مشابه.

تلاش های دیگری در دانشگاه ها و آزمایشگاه های تحقیقاتی شامل استفاده از یادگیری دیپ فیک برای کشف مناطق اصلاح شده در تصاویر گرفته تا استفاده از تکنولوژی بلاکچین برای ایجاد حقیقت زمینی و ثبت فیلم های قابل اعتماد است.

در کل محققان بر این باورند که مبارزه با آن به یک تعقیب موش و گربه تبدیل شده است. همانطور که سال گذشته یکی از محققان اظهار داشت: “هر کاری انجام دهیم، افرادی که این دستکاری ها را ایجاد می کنند با چیز تازه تری روبرو می شوند. ما نمی دانیم آیا زمانی وجود خواهد داشت که بتوانیم هر نوع دستکاری را تشخیص دهیم یا خیر.”